Hasta una semana, la hostilidad entre Oracle y SAP por lo que podríamos denominar la cuota de mercado de las bases de datos con procesamiento en memoria (in-memory Computing) parecía más ilusión de la prensa, pero por lo visto en los últimos días, la “guerra es abierta” y el “combate es cuerpo a cuerpo”.

Hasta una semana, la hostilidad entre Oracle y SAP por lo que podríamos denominar la cuota de mercado de las bases de datos con procesamiento en memoria (in-memory Computing) parecía más ilusión de la prensa, pero por lo visto en los últimos días, la “guerra es abierta” y el “combate es cuerpo a cuerpo”.

Oracle no cesa en afirmar que SAP HANA no es producto que pueda afectar a su tradicional negocio de base de datos, pero cada vez que tiene que hablar de sus propuestas in-Memory, habla de SAP HANA, algo similar como lo que sucede con aquel entrenador de futbol que cuando debe hablar de su equipo, habla de otro equipo.

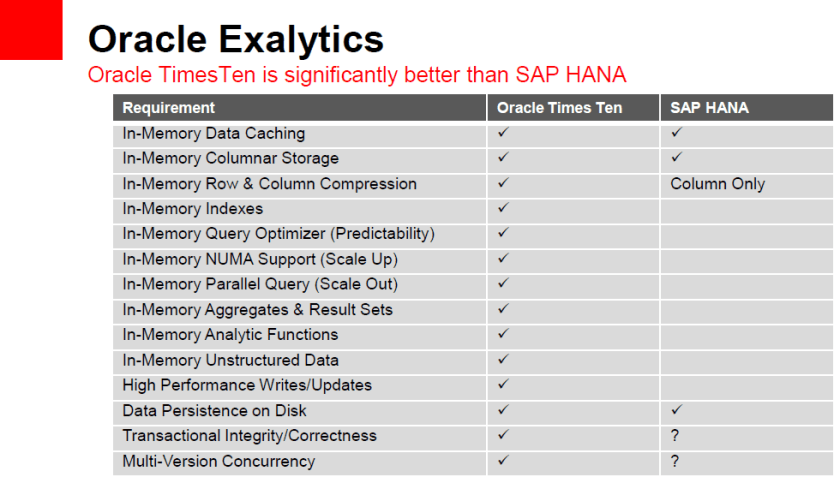

Hace una semana Oracle publicaba una presentación que ha desatado la furia en SAP, generando respuestas inmediatas hasta del Vicepresidente Ejecutivo de SAP, Steve Lucas, quién ha considerado el documento de referencia un ataque por la cantidad de errores e inexactitudes que contiene.

No conocemos la propuesta in-memory de Oracle, pero particularmente nos parece algo compleja, repartida entre Exadata (entendemos que es la base de datos in-memory genérica) y Exalytics (la propuesta in-memory para necesidades de Business Intelligence) que al parecer, vista la documentación, necesitaríamos “vincular”.

Comparar Oracle Exalytics con SAP HANA, nos parece tan “lógico” como comparar naranjas con manzanas, las dos pueden ser muy buenas, pero responden a necesidades distintas. Oracle la percibimos como una base de datos y SAP HANA como una plataforma sobre la que se están desarrollando una nueva generación de aplicaciones, inclusive SAP ERP.

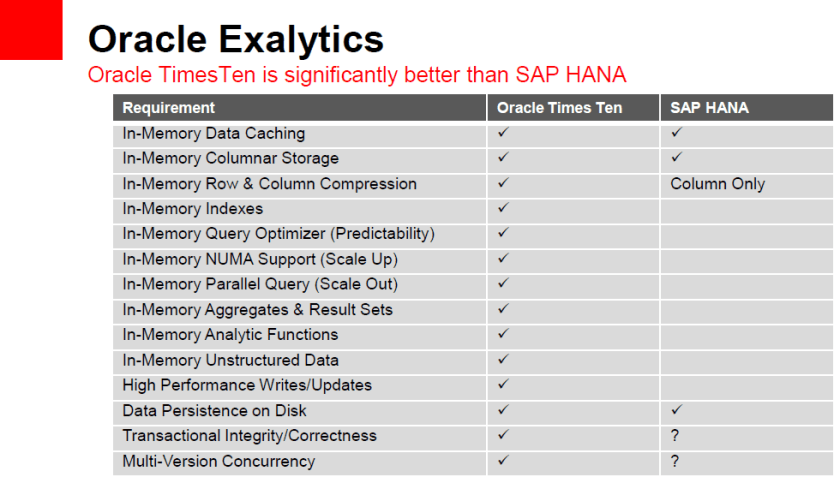

Unos de los aspectos que más críticas a suscitado ha sido la comparativa de funcionalidades entre Oracle Exalytics y SAP HANA, una primera impresión podría conllevar a la conclusión que la propuesta de Oracle “tiene más” o “es mejor”, pero resulta que la mayoría de características que figuran en esta tabla, tales como los agregados o índices, no son incluidas en la tecnología de SAP porque son innecesarias y no contribuyen a una mejor eficiencia. Como señala el post de Steve Lucas, es como comparar la tecnología de un carruaje tirado por caballos y un automóvil, el primero ya puede señalar que incluye el cubo y una pala para recoger los excrementos de los animales.

Otro aspecto que para SAP es incorrecto, es la referencia de precios, en el artículo del Vicepresidente de SAP, se señala que se cobra por la estimación de datos a procesar, según esto se determina las necesidades memoria y unidades a utilizar (1 unidad = 64 GB) la cual valdría a 13 euros por unidad. Si algo tienen en común estas tecnologías es que utilizan un hardware específico, pero mientras de Oracle es sólo Sun, SAP HANA está disponible con el hardware de Fujitsu, Dell, IBM y HP.

Nuestra apuesta para procesamiento in-memory es SAP HANA. Al igual que otras opiniones, tenemos la sensación que las propuestas de Oracle han sido diseñadas apresuradamente sobre su modelo tradicional de bases de datos y no descartamos que en el futuro inmediato presenten un nuevo producto.

Referencia: (documento de Oracle)